Практически 30% контента на интернет-страницах — дубликат

На очередном обучающий уроке для всех владельцев интернет-сайтов, глава команды Google по борьбе с веб-спамом Мэтт Катс снова заговорил о наболевшей проблеме — дублирование контента и кража уникальных статей. Спровоцировал разговор один из пользователей Великобритании, который поинтересовался о том, как Гугл работает над выявлением и ликвидацией дубликатов в сети интернет, а также, каким образом это влияет на дальнейшую оптимизацию и развитие сайта.

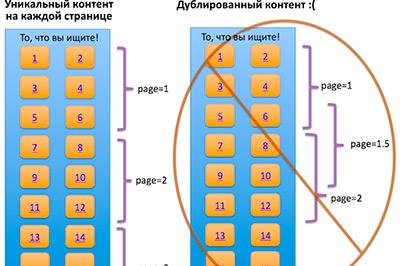

На этот вопрос Каттс очень спокойно стал пояснять, что на сегодняшний день, действительно практически 25-30% материала в сети интернет действительно дубликат, так как люди просто цитируют прямую речь, целые параграфы из блогов, после чего, естественно ссылаются на данные блоги. Именно поэтому, раскрутка сайтов с такой информацией не может быть наказана, а данный контент нельзя относить в категорию веб-спама. Он пояснил, что компания намеренно сделала для этого специальное различие. Однако он также пояснил, что в дальнейшем, компания будет отдавать предпочтение первоисточнику, а проходить будет лишь одна дублированная страница.

Мэтт Каттс еще добавил: «Гораздо больше проблем возникает с теми, кто пытается автоматически генерировать контент на своих ресурсах при помощи RSS-фидов. Как правило, такой контент не имеет добавочной ценности и похож на веб-спам. Однако, если вы создаёте региональные версии сайтов, к примеру, в зонах .com и .co.uk – то вам следует прописать «Условия» для каждого ресурса отдельно». Он также порекомендовал всем владельцам сайтов иметь ключевой контент, который после может отображаться и на других ресурсах, такое расположение не будет считаться критичным.

Related Images:

Сергей Пабликанов

Главный редактор “Россия-онлайн”

Темы новости

Все новости лентой

за 20 ноября 2024 года